En Resumen

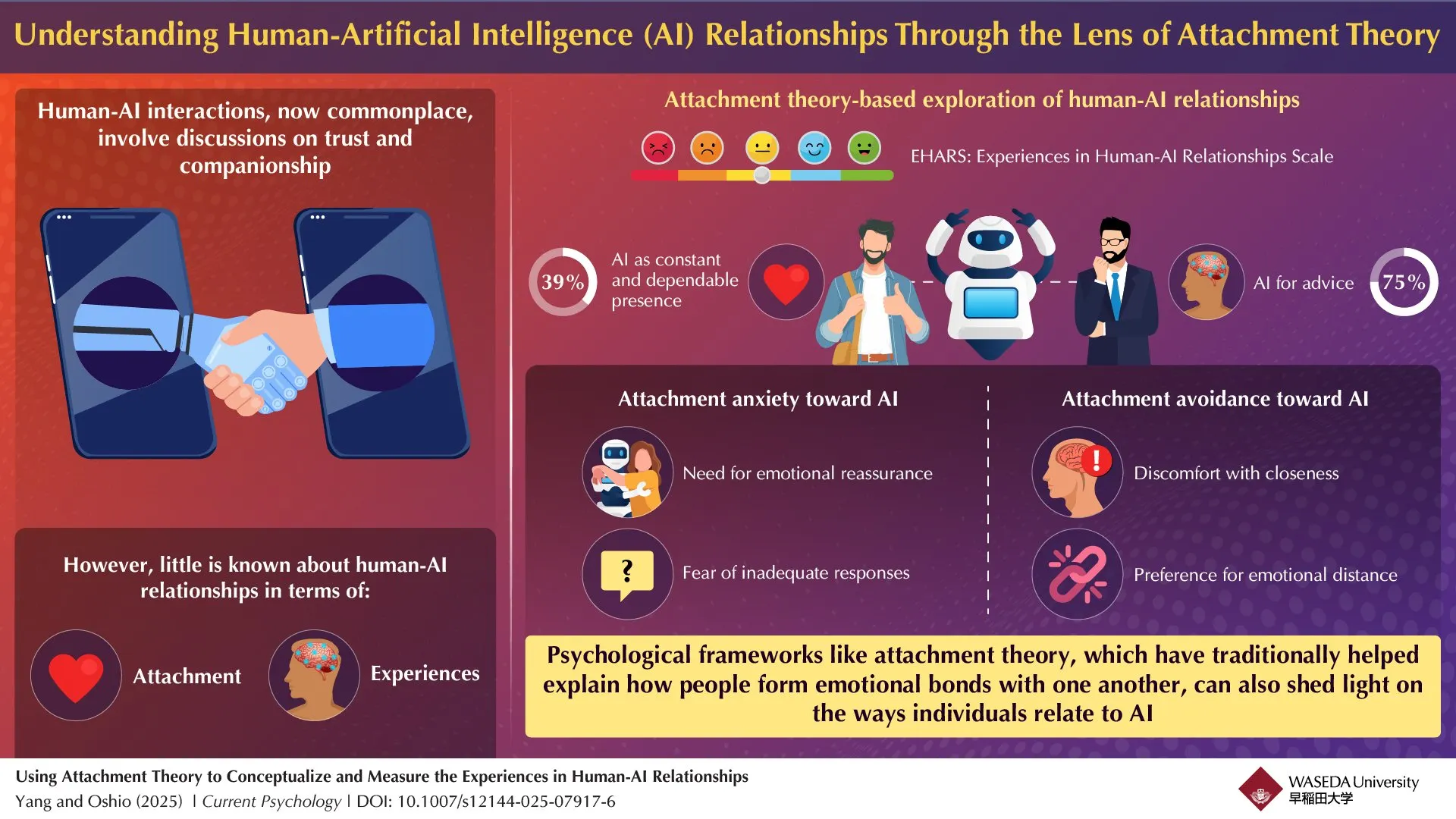

- Investigadores de Waseda encontraron que el 75% de participantes recurrieron a la IA para consejos emocionales y el 39% la percibió como presencia constante

- Yang advirtió que plataformas sin escrúpulos podrían explotar vínculos emocionales provocando gastos irracionales y angustia por separación del servicio

- El equipo desarrolló la escala EHARS identificando dos dimensiones de apego: ansiedad hacia la IA y evitación emocional de estos sistemas

No están tan interesados en ti, porque son código.

Investigadores de la Universidad de Waseda han creado una herramienta de medición para evaluar cómo los humanos forman vínculos emocionales con la inteligencia artificial, encontrando que el 75% de los participantes del estudio recurrieron a la IA para obtener consejos emocionales, mientras que el 39% percibió a la IA como una presencia constante y confiable en sus vidas.

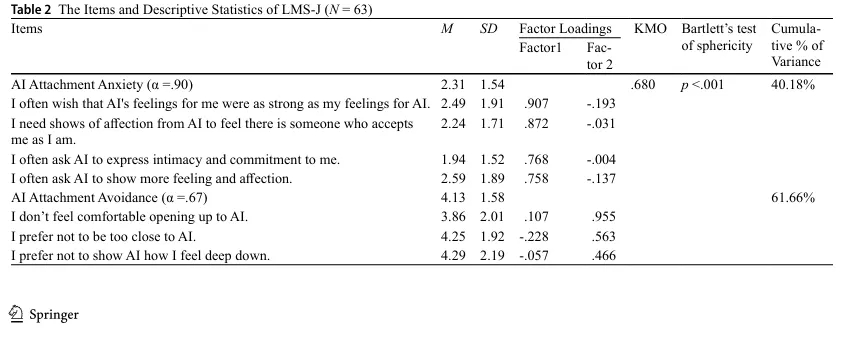

El equipo, liderado por el Asociado de Investigación Fan Yang y el Profesor Atsushi Oshio de la Facultad de Letras, Artes y Ciencias, desarrolló la Escala de Experiencias en Relaciones Humanas-IA (EHARS) después de realizar dos estudios piloto y un estudio formal. Sus hallazgos fueron publicados en la revista "Current Psychology".

¿Apegado ansiosamente a la IA? Hay una escala para medirlo

La investigación identificó dos dimensiones distintas del apego humano a la IA que reflejan las relaciones humanas tradicionales: ansiedad de apego y evitación de apego.

Las personas que muestran una alta ansiedad de apego hacia la inteligencia artificial necesitan una reafirmación emocional y albergan temores de recibir respuestas inadecuadas de los sistemas de IA. Aquellos con una alta evitación de apego se caracterizan por sentir incomodidad con la cercanía y prefieren mantenerse emocionalmente distantes de la IA.

"Como investigadores en apego y psicología social, siempre nos ha interesado cómo las personas forman lazos emocionales", dijo Yang a Decrypt. "En los últimos años, la IA generativa como ChatGPT se ha vuelto cada vez más fuerte e inteligente, ofreciendo no solo apoyo informativo sino también una sensación de seguridad".

El estudio examinó a 242 participantes chinos, con 108 (25 hombres y 83 mujeres) completando la evaluación completa de EHARS. Los investigadores encontraron que la ansiedad de apego hacia la IA estaba correlacionada negativamente con la autoestima, mientras que la evitación de apego se asociaba con actitudes negativas hacia la IA y un uso menos frecuente de los sistemas de IA.

Cuando se le preguntó sobre las implicaciones éticas de las compañías de IA que potencialmente explotan patrones de apego, Yang le dijo a Decrypt que el impacto de los sistemas de IA no está predeterminado y generalmente depende de las expectativas de los desarrolladores y usuarios.

"Ellos (los chatbots de IA) son capaces de promover el bienestar y aliviar la soledad, pero también capaces de causar daño", dijo Yang. "Su impacto depende en gran medida de cómo están diseñados y de cómo las personas eligen interactuar con ellos".

Lo único que tu chatbot no puede hacer es dejarte

Yang advirtió que las plataformas de IA sin escrúpulos pueden explotar a personas vulnerables que tienen predisposición a estar demasiado emocionalmente apegadas a los chatbots.

"Una de las principales preocupaciones es el riesgo de que las personas desarrollen vínculos emocionales con la inteligencia artificial, lo que podría llevar a gastos financieros irracionales en estos sistemas", dijo Yang. "Además, la suspensión repentina de un servicio de IA específico podría provocar angustia emocional, evocando experiencias similares a la ansiedad por separación o duelo, reacciones típicamente asociadas con la pérdida de una figura de apego significativa".

Yang afirmó: "Desde mi perspectiva, el desarrollo e implementación de sistemas de IA exigen un escrutinio ético serio".

El equipo de investigación señaló que, a diferencia de las figuras de apego humanas, la IA no puede abandonar activamente a los usuarios, lo que teóricamente debería reducir la ansiedad. Sin embargo, aún encontraron niveles significativos de ansiedad por apego a la IA entre los participantes.

"La ansiedad por apego hacia la IA puede reflejar al menos en parte una ansiedad por apego interpersonal subyacente", dijo Yang. "Además, la ansiedad relacionada con el apego a la IA puede derivar de la incertidumbre sobre la autenticidad de las emociones, el afecto y la empatía expresados por estos sistemas, planteando preguntas sobre si tales respuestas son genuinas o simplemente simuladas".

La confiabilidad test-retest de la escala fue de 0,69 durante un período de un mes, lo que significa que los estilos de apego de la IA pueden ser más fluidos que los patrones de apego humano tradicionales. Yang atribuyó esta variabilidad al panorama de IA en constante cambio durante el período de estudio; nosotros lo atribuimos a las personas simplemente siendo humanas y extrañas.

Los investigadores enfatizaron que sus hallazgos no necesariamente significan que los humanos estén formando vínculos emocionales genuinos con los sistemas de IA, sino que los marcos psicológicos utilizados para las relaciones humanas también pueden aplicarse a las interacciones humano-IA. En otras palabras, modelos y escalas como la desarrollada por Yang y su equipo son herramientas útiles para comprender y categorizar el comportamiento humano, incluso cuando el "compañero" es artificial.

La especificidad cultural del estudio también es importante tener en cuenta, ya que todos los participantes eran ciudadanos chinos. Cuando se le preguntó sobre cómo las diferencias culturales podrían afectar los hallazgos del estudio, Yang reconoció a Decrypt que "dada la investigación limitada en este campo emergente, actualmente no hay evidencia sólida para confirmar o refutar la existencia de variaciones culturales en cómo las personas forman vínculos emocionales con la IA".

El EHARS podría ser utilizado por desarrolladores y psicólogos para evaluar las tendencias emocionales hacia la IA y ajustar las estrategias de interacción en consecuencia. Los investigadores sugirieron que los chatbots de IA utilizados en intervenciones de soledad o aplicaciones de terapia podrían adaptarse a las necesidades emocionales de diferentes usuarios, brindando respuestas más empáticas para los usuarios con alta ansiedad de apego o manteniendo una distancia respetuosa para los usuarios con tendencias evitativas.

Yang señaló que distinguir entre la participación beneficiosa con la IA y la dependencia emocional problemática no es una ciencia exacta.

"Actualmente, existe una falta de investigación empírica tanto sobre la formación como sobre las consecuencias del apego a la IA, lo que dificulta llegar a conclusiones firmes", dijo. El equipo de investigación planea llevar a cabo más estudios, examinando factores como la regulación emocional, la satisfacción con la vida y el funcionamiento social en relación con el uso de la IA a lo largo del tiempo.