En Resumen

- Sam Altman confirmó que GPT-5 se lanzaría "probablemente en algún momento de este verano", fusionando las capacidades de todos los modelos anteriores en un sistema único.

- Los expertos predicen que el modelo tendrá una ventana de contexto de hasta 2 millones de tokens y capacidades multimodales unificadas para texto, imágenes y audio.

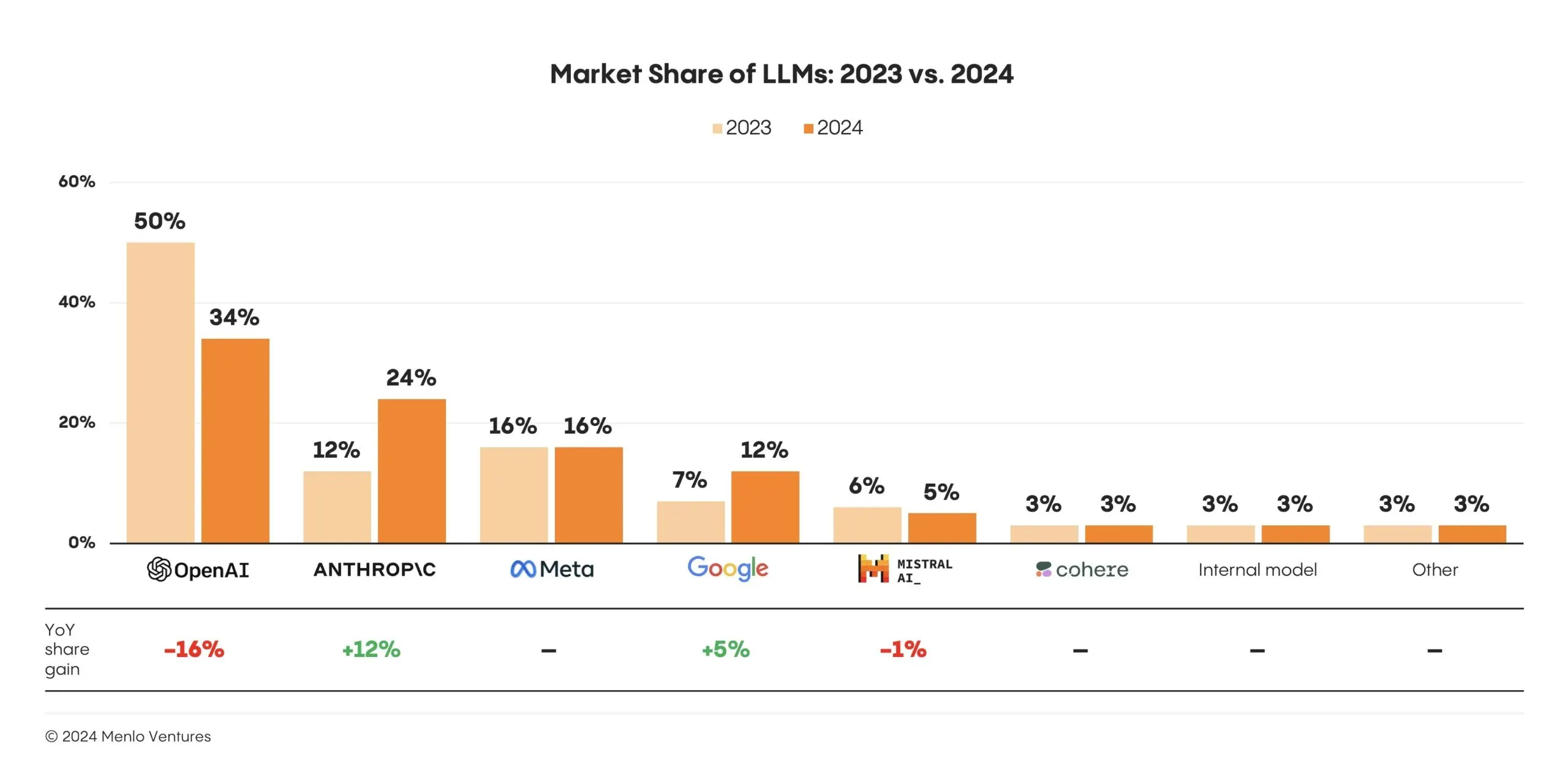

- La cuota de mercado empresarial de OpenAI se desplomó del 50% al 34% mientras competidores como Anthropic y Google cerraron rápidamente la brecha tecnológica.

Cuidado: se espera que GPT-5 de OpenAI se lance este verano. ¿Será un éxito de inteligencia artificial?

Sam Altman confirmó el plan en junio durante el primer episodio de podcast de la compañía, mencionando casualmente que el modelo, el cual, según ha dicho, fusionará las capacidades de sus modelos anteriores, llegaría "probablemente en algún momento de este verano".

Algunos observadores de OpenAI predicen que llegará en las próximas semanas. Un análisis del historial de lanzamientos de modelos de OpenAI señaló que GPT-4 se lanzó en marzo de 2023 y GPT-4-Turbo (que impulsa ChatGPT) llegó más tarde en noviembre de 2023. GPT-4o, un modelo más rápido y multimodal, se lanzó en mayo de 2024. Esto significa que OpenAI ha estado refinando e iterando modelos más rápidamente.

Pero no fue lo suficientemente rápido para el mercado de IA brutalmente rápido y competitivo. En febrero, Altman dijo cuando se le pregunto en X cuándo se lanzaría GPT-5 que podría ser lanzado en "semanas/meses". De hecho, las semanas se han convertido en meses, y mientras tanto, los competidores han estado cerrando rápidamente la brecha, con Meta gastando miles de millones de dólares durante los últimos 10 días para contratar a algunos de los principales científicos de OpenAI.

Según Menlo Ventures, la cuota de mercado empresarial de OpenAI se desplomó del 50% al 34%, mientras que Anthropic se duplicó del 12% al 24%. Gemini 2.5 Pro de Google destruyó absolutamente a la competencia en razonamiento matemático, y DeepSeek R-1 se convirtió en sinónimo de "revolucionario", venciendo a las alternativas de código cerrado, e incluso Grok de xAI (anteriormente conocido simplemente por su configuración de "modo divertido") comenzó a ser tomado en serio entre los programadores.

Qué esperar de GPT-5

El próximo modelo GPT, según Altman, será efectivamente un modelo para gobernarlos a todos.

Se espera que GPT-5 unifique los diversos modelos y herramientas de OpenAI en un sistema único, eliminando la necesidad de un "selector de modelos". Los usuarios ya no tendrán que elegir entre diferentes modelos especializados, ya que un sistema manejará texto, imágenes, audio y potencialmente video.

Hasta ahora, estas tareas se distribuyen entre GPT-4.1, Dall-E, GPT-4o, o3, Voz Avanzada, Visión y Sora. Concentrar todo en un único modelo verdaderamente multimodal es un logro bastante importante.

GPT 5 = level 4 on AGI scale.

Now compute is all that's needed to multiply agents x1000 and they can work autonomously on Organisatzions.

"Sam discusses future direction of development; "GPT-5 and GPT-6, [...], will utilize reinforcement learning and will be like discovering… https://t.co/ewhrZRemey pic.twitter.com/UpS0aMUfJY

— Chubby♨️ (@kimmonismus) February 3, 2025

Los detalles técnicos también lucen ambiciosos. Se proyecta que el modelo cuente con una ventana de contexto significativamente ampliada, potencialmente superando 1 millón de tokens, y algunos informes especulan que incluso alcanzará los 2 millones de tokens. Para ponerlo en contexto, GPT-4o tiene un límite de 128.000 tokens. Esa es la diferencia entre procesar un capítulo y digerir un libro entero.

OpenAI comenzó a implementar características experimentales de memoria en GPT-4-Turbo en 2024, permitiendo al asistente recordar detalles como el nombre de un usuario, preferencias de tono y proyectos en curso. Los usuarios pueden ver, actualizar o eliminar estos recuerdos, que se construyen gradualmente con el tiempo en lugar de basarse en interacciones individuales.

En GPT-5, se espera que la memoria se integre de manera más profunda y fluida, después de todo, el modelo podrá procesar casi 100 veces más información sobre ti, con potencialmente 2 millones de tokens en lugar de 80.000. Esto permitiría al modelo recordar conversaciones semanas más tarde, construir conocimiento contextual con el tiempo y ofrecer una continuidad más similar a la de un asistente digital personalizado.

Las mejoras en el razonamiento suenan igualmente ambiciosas. Se anticipa que este avance se manifieste como un cambio hacia el procesamiento de "cadena de pensamiento estructurada", permitiendo que el modelo desglose problemas complejos en secuencias lógicas y multi-paso, reflejando los procesos de pensamiento deliberativo humanos.

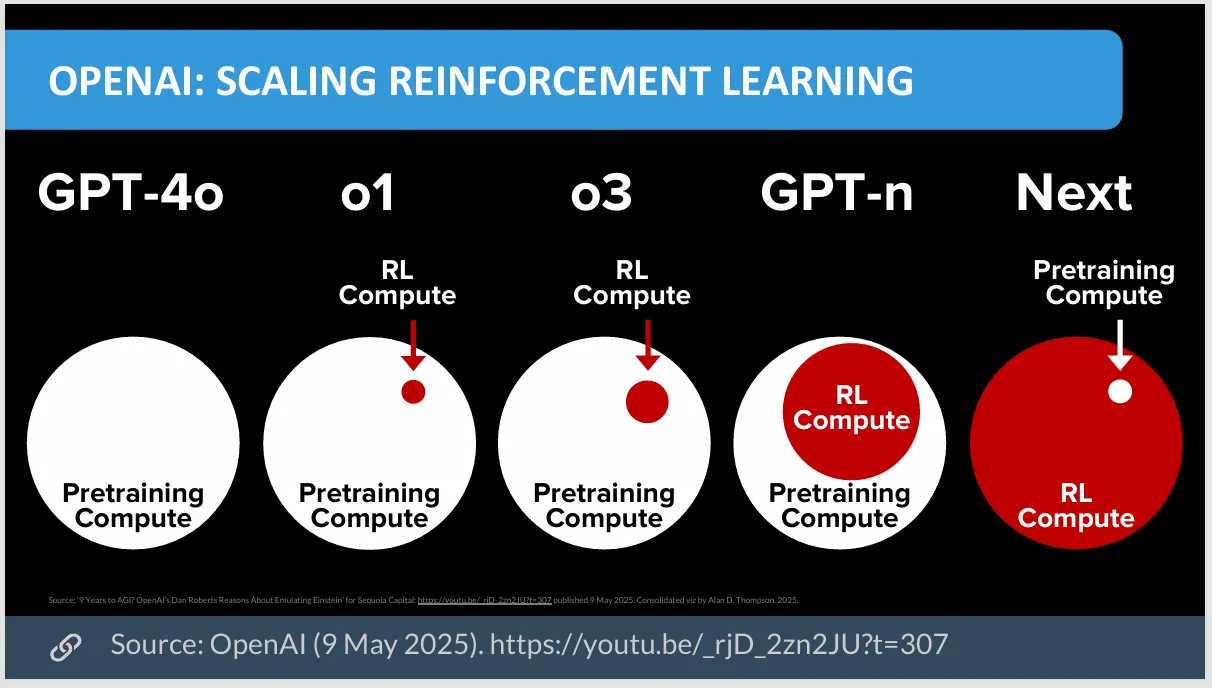

En cuanto a los parámetros, los rumores de consenso van desde 10 a 50 billones, hasta un llamativo un cuatrillón. Sin embargo, como ha dicho Altman, "la era del escalado de parámetros ya ha terminado", ya que las técnicas de entrenamiento de IA cambian el enfoque de la cantidad a la calidad, con enfoques de aprendizaje mejores que hacen que los modelos más pequeños sean extremadamente potentes.

Y este es otro problema fundamental para OpenAI: Se está quedando sin datos de internet para entrenar. ¿La solución? Hacer que la IA genere sus propios datos de entrenamiento, lo que podría marcar una nueva era en el entrenamiento de IA.

Los expertos dan su opinión

"El próximo salto será la generación de datos sintéticos en dominios verificables," Andrew Hill, CEO del agente de IA en la arena on-chain Recall, le dijo a Decrypt. "Estamos encontrando obstáculos en los datos a escala de internet, pero los avances en el razonamiento muestran que los modelos pueden generar datos de entrenamiento de alta calidad cuando se tienen mecanismos de verificación. Los ejemplos más simples son problemas matemáticos donde se puede verificar si la respuesta es correcta, y código donde se pueden ejecutar pruebas unitarias".

Hill ve esto como transformador: "El salto consiste en crear nuevos datos que en realidad son mejores que los datos generados por humanos porque se refinan de forma iterativa a través de bucles de verificación, y se crean mucho más rápido".

Los puntos de referencia son otro campo de batalla: el experto en IA y educador David Shapiro espera que el modelo alcance el 95% en MMLU, y aumente del 32% al 82% en SWEBench, básicamente un modelo de IA de nivel divino. Si incluso la mitad de eso es cierto, GPT-5 será noticia. Y internamente, hay una confianza real, con incluso algunos investigadores de OpenAI entusiasmando sobre el modelo antes de su lanzamiento.

It’s wild watching people use ChatGPT now, knowing what’s coming.

— Tristan (@ItsTKai) June 12, 2025

No creas en la exageración

Los expertos entrevistados por Decrypt advirtieron que cualquiera que espere que GPT-5 alcance niveles de capacidad de AGI debería contener su entusiasmo. Hill dijo que espera un "paso incremental, disfrazado de revolución".

Wyatt Mayham, CEO de Consultoría de IA del Noroeste, fue un poco más allá, prediciendo que GPT-5 probablemente sería "un salto significativo en lugar de uno incremental", agregando "Esperaría ventanas de contexto más largas, más multimodalidad nativa y cambios en cómo los agentes pueden actuar y razonar. No estoy apostando por una solución milagrosa en absoluto, pero creo que GPT-5 debería ampliar el tipo de herramientas que podemos enviar con confianza a los usuarios".

GPT-5 further confirmed to be a core omni-modal reasoning model capable of both quick responses and long reasoning. pic.twitter.com/DTlCadJvGs

— Chubby♨️ (@kimmonismus) February 16, 2025

Con cada dos pasos adelante viene uno en retroceso, dijo Mayham: "Cada lanzamiento importante resuelve las limitaciones más obvias de la generación anterior mientras introduce nuevas".

GPT-4 solucionó las brechas de razonamiento de GPT-3, pero se encontró con barreras de datos. Los modelos de razonamiento (o3) solucionaron el pensamiento lógico, pero son costosos y lentos.

Tony Tong, CTO en Intellectia AI—una plataforma que proporciona información de IA para inversores—también es cauteloso, esperando un mejor modelo pero no algo que cambie el mundo como muchos hiperentusiastas de la IA. "Apuesto a que GPT-5 combinará un razonamiento multimodal más profundo, una mejor fundamentación en herramientas o memoria, y grandes avances en alineación y control del comportamiento agente," dijo Tong a Decrypt. "Piensa: más controlable, más confiable y más adaptable".

Y Patrice Williams-Lindo, CEO en Career Nomad, predijo que GPT-5 no será mucho más que una "revolución incremental". Sin embargo, sospecha que podría ser especialmente bueno para los usuarios diarios de IA en lugar de aplicaciones empresariales.

"Los efectos compuestos de confiabilidad, memoria contextual, multimodalidad y tasas de error más bajas podrían ser revolucionarios en cuanto a cómo las personas realmente confían y utilizan estos sistemas a diario. Esto por sí solo podría ser una gran victoria," dijo Williams-Lindo.

Algunos expertos simplemente son escépticos de que GPT-5—o cualquier otro LLM—será recordado por mucho en absoluto.

El investigador de IA Gary Marcus, quien ha sido crítico de los enfoques de escalamiento puro (mejores modelos necesitan más parámetros), escribió en sus habituales predicciones para el año: "Podría seguir sin existir un modelo de nivel 'GPT-5' (lo que significa un gran avance general según el consenso de la comunidad) a lo largo de 2025".

Marcus apuesta por anuncios de actualizaciones en lugar de modelos fundamentales completamente nuevos. Dicho esto, esta es una de sus suposiciones de baja confianza.

La fuga de cerebros de miles de millones de dólares

Si el asalto de Mark Zuckerberg al talento de OpenAI retrasa el lanzamiento de GPT-5 es una incógnita, aunque

"Definitivamente está frenando sus esfuerzos", dijo David A. Johnston, líder del mantenimiento de código en la red de IA descentralizada Morpheus, a Decrypt. Además del dinero, Johnston cree que el talento superior está motivado moralmente para trabajar en iniciativas de código abierto como Llama en lugar de alternativas de código cerrado como ChatGPT o Claude.

Aun así, algunos expertos piensan que el proyecto ya está tan evolucionado que la fuga de talentos no lo afectará.

Mayham afirmó que "el lanzamiento de julio de 2025 parece realista. Incluso con algunos talentos clave yéndose a Meta, creo que OpenAI todavía parece estar en camino. Han mantenido el liderazgo central y ajustado la compensación para estabilizarse un poco, parece".

Williams-Lindo agregó: "El impulso y el flujo de capital de OpenAI son sólidos. Lo más impactante no es quién se fue, sino cómo aquellos que se quedan recalibran sus prioridades, especialmente si se centran en la productización o se detienen para abordar presiones de seguridad o legales".

Si la historia sirve de guía, el mundo pronto verá la revelación de GPT-5, junto con una avalancha de titulares, opiniones rápidas y momentos de "¿Eso es todo?". Y luego, justo así, toda la industria comenzará a hacer la siguiente gran pregunta que importa: ¿Cuándo GPT-6?