En Resumen

- Model Context Protocol lanzado por Anthropic en noviembre de 2024 permite conectar modelos de IA locales con herramientas externas sin enviar datos a servidores corporativos.

- Brave Search ofrece 2.000 consultas mensuales gratuitas y Tavily proporciona 1.000 créditos al mes para búsquedas web con total privacidad.

- Modelos como DeepSeek R1, Llama-3.2 3b Instruct y GPT-oss soportan tool calling y funcionan en computadoras de consumo con LM Studio versión 0.3.17 o superior.

¿Quieres una IA que pueda navegar por la web y crees que las únicas opciones son de OpenAI, Anthropic o Google?

Piénsalo de nuevo.

Tus datos no necesitan viajar a través de servidores corporativos cada vez que tu asistente de IA necesita información oportuna. Con los servidores del Model Context Protocol (MCP), puedes dar incluso a modelos ligeros de consumo la capacidad de buscar en la web, analizar artículos y acceder a datos en tiempo real, todo mientras mantienes privacidad completa y gastas cero dólares.

¿La trampa? No hay ninguna. Estas herramientas ofrecen niveles gratuitos generosos: Brave Search proporciona 2.000 consultas mensuales, Tavily ofrece 1.000 créditos, y ciertas opciones no requieren clave API en absoluto. Para la mayoría de usuarios, eso es suficiente margen para nunca alcanzar un límite... es muy dificil que hagas 1.000 búsquedas en un día.

Antes de ponernos técnicos, hay que explicar dos conceptos. "Model Context Protocol" es un estándar abierto lanzado por Anthropic en noviembre de 2024 que permite a los modelos de IA conectarse con herramientas externas y fuentes de datos. Piénsalo como una especie de adaptador universal que conecta módulos tipo Tinkertoy que añaden utilidad y funcionalidad a tu modelo de IA.

En lugar de decirle a tu IA exactamente qué hacer (que es lo que hace una llamada API), le dices al modelo qué necesitas y simplemente descubre por sí mismo qué hacer para lograr ese objetivo. Los MCP no son tan precisos como las llamadas API tradicionales, y probablemente gastarás más tokens para hacerlos funcionar, pero son mucho más versátiles.

"Tool calling", a veces llamado function calling, es el mecanismo que hace que esto funcione. Es la capacidad de un modelo de IA de reconocer cuándo necesita información externa e invocar la función apropiada para obtenerla. Cuando preguntas "¿Cuál es el clima en Río de Janeiro?", un modelo con tool calling puede identificar que necesita llamar a una API meteorológica o servidor MCP, formatear la solicitud correctamente e integrar los resultados en su respuesta. Sin soporte de tool-calling, tu modelo solo puede trabajar con lo que aprendió durante el entrenamiento.

Aquí te mostramos cómo dar superpoderes a tu modelo local.

Requisitos técnicos y configuración

Los requisitos son mínimos: necesitas Node.js instalado en tu computadora, así como una aplicación de IA local que soporte MCP (como LM Studio versión 0.3.17 o superior, Claude Desktop o Cursor IDE), y un modelo con capacidades de tool calling.

También deberías tener Python instalado.

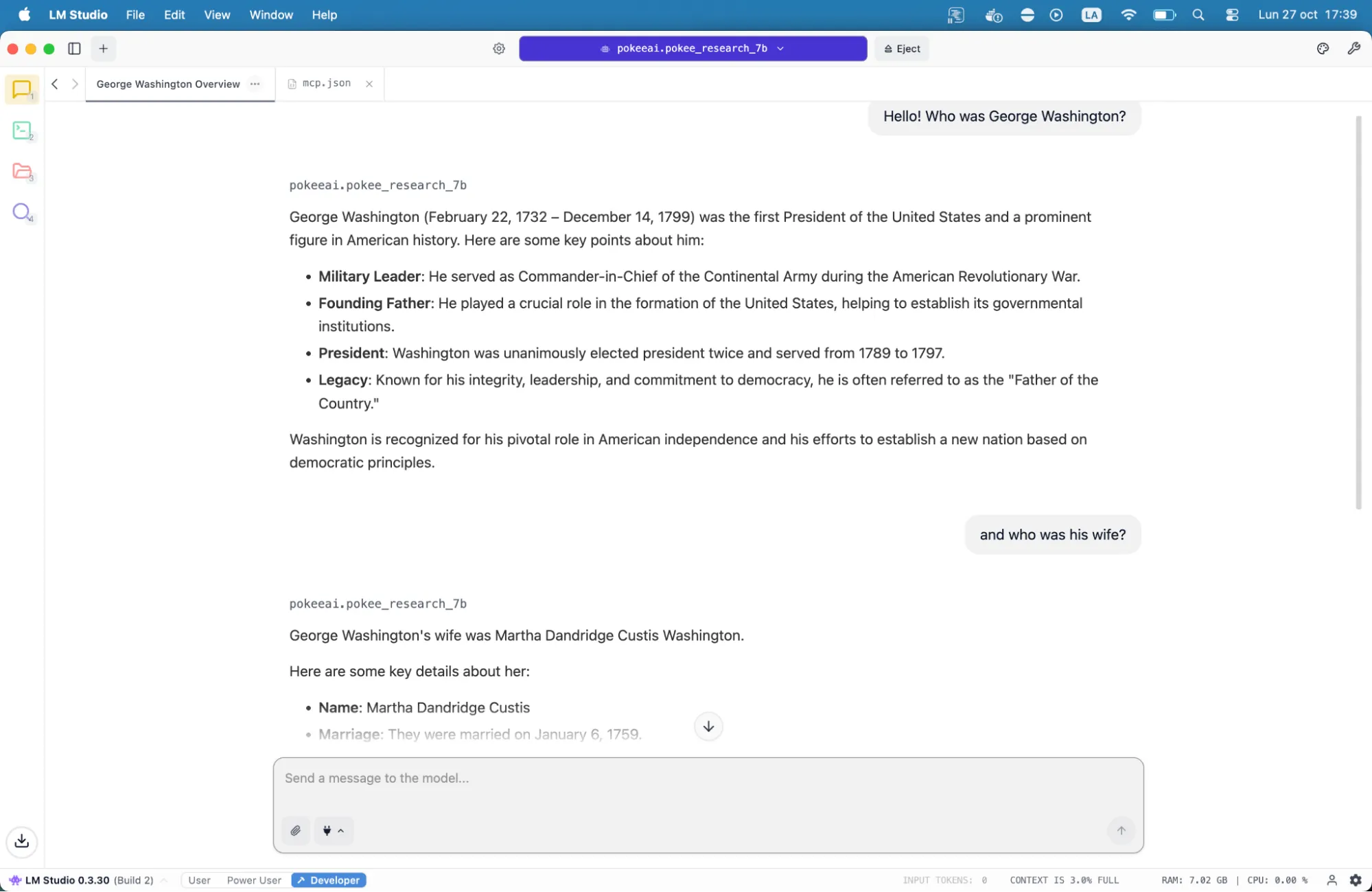

Algunos buenos modelos con tool-calling que funcionan en máquinas de grado consumidor son GPT-oss, DeepSeek R1 0528, Jan-v1-4b, Llama-3.2 3b Instruct y Pokee Research 7B.

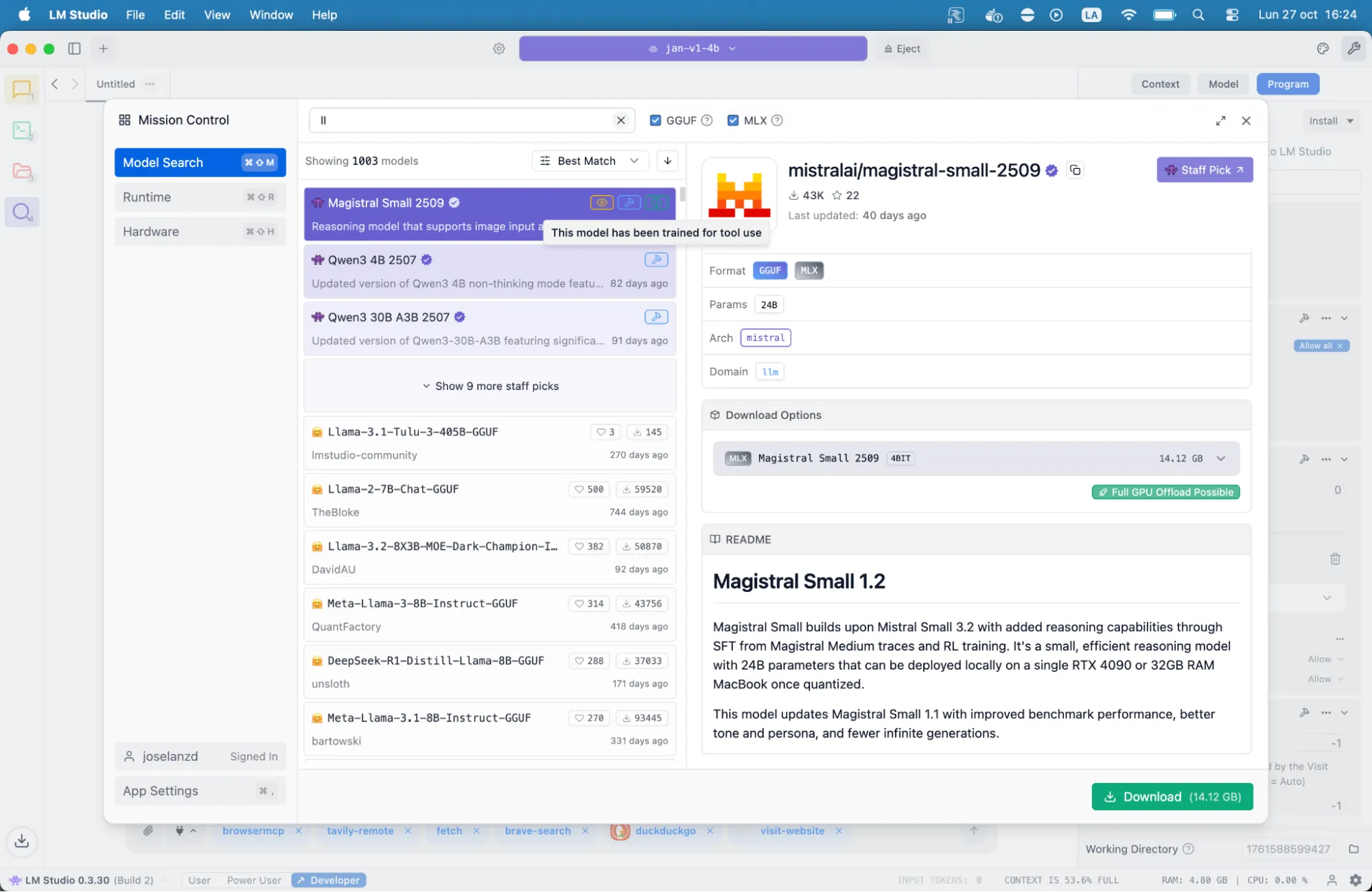

Para instalar un modelo, ve al ícono de lupa en la barra lateral izquierda en LM Studio y busca uno. Los modelos que soportan herramientas mostrarán un ícono de martillo cerca de su nombre. Esos son los que necesitarás.

La mayoría de los modelos modernos por encima de 7 mil millones de parámetros soportan tool calling: Qwen3, DeepSeek R1, Mistral y arquitecturas similares funcionan bien. Mientras más pequeño sea el modelo, más podrías necesitar pedirle explícitamente que use herramientas de búsqueda, pero incluso modelos de 4 mil millones de parámetros pueden manejar acceso web básico.

Una vez que hayas descargado el modelo, necesitas "cargarlo" para que LM Studio sepa que debe usarlo. No quieres que tu modelo de roleplay erótico haga la investigación para tu tesis.

Configurando motores de búsqueda

La configuración ocurre a través de un único archivo mcp.json. La ubicación depende de tu aplicación: LM Studio usa su interfaz de configuración para editar este archivo, Claude Desktop busca en directorios de usuario específicos, y otras aplicaciones tienen sus propias convenciones. Cada entrada de servidor MCP requiere solo tres elementos: un nombre único, el comando para ejecutarlo y cualquier variable de entorno requerida como claves API.

Pero realmente no necesitas saber eso: solo copia y pega la configuración que los desarrolladores proporcionan, y funcionará. Si no quieres meterte con ediciones manuales, entonces al final de esta guía encontrarás una configuración, lista para copiar y pegar, para que puedas tener algunos de los servidores MCP más importantes listos para trabajar.

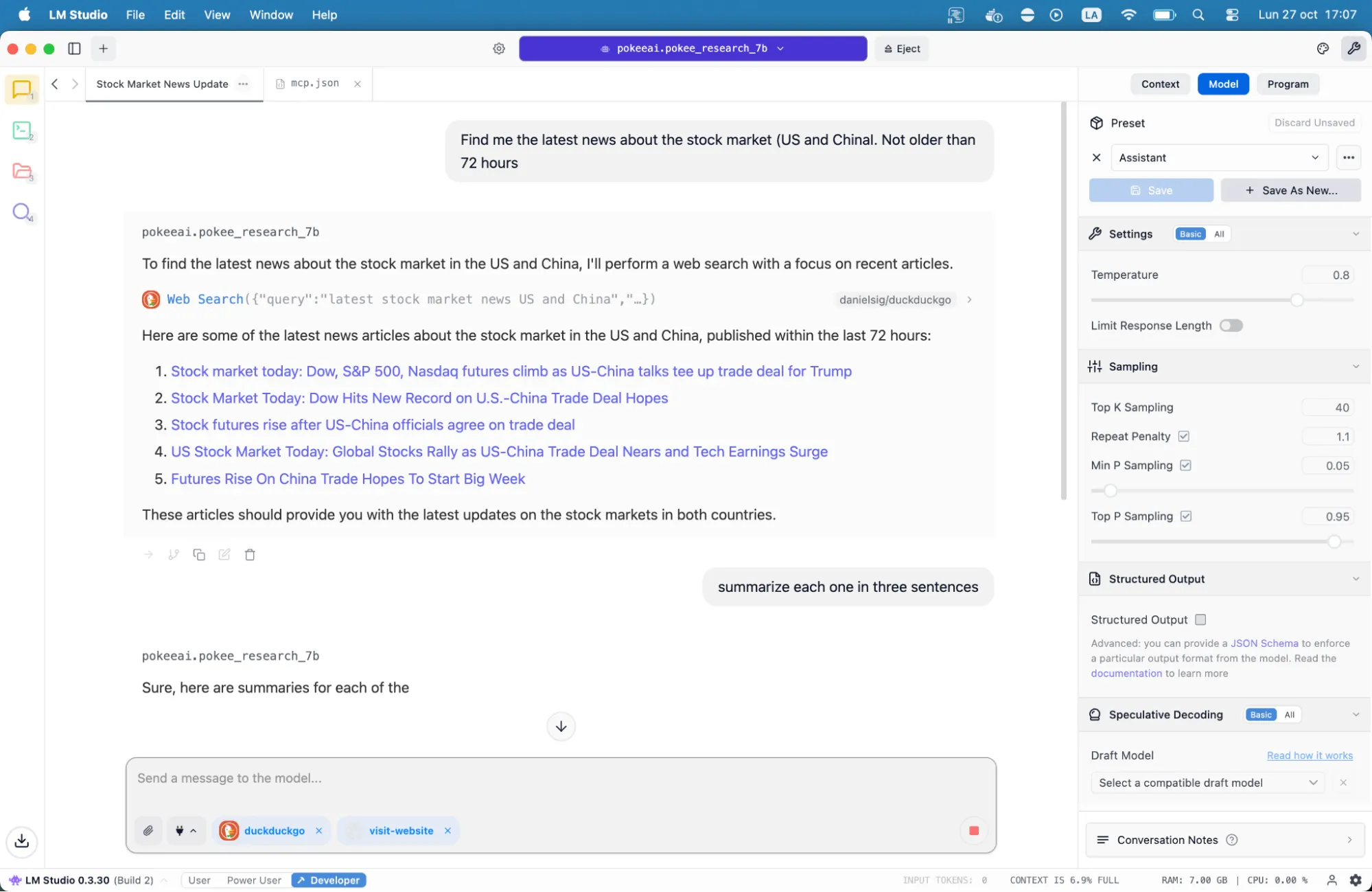

Las tres mejores herramientas de búsqueda disponibles a través de MCP traen diferentes fortalezas. Brave se enfoca en privacidad, Tavily es más versátil y DuckDuckGo es la más fácil de implementar.

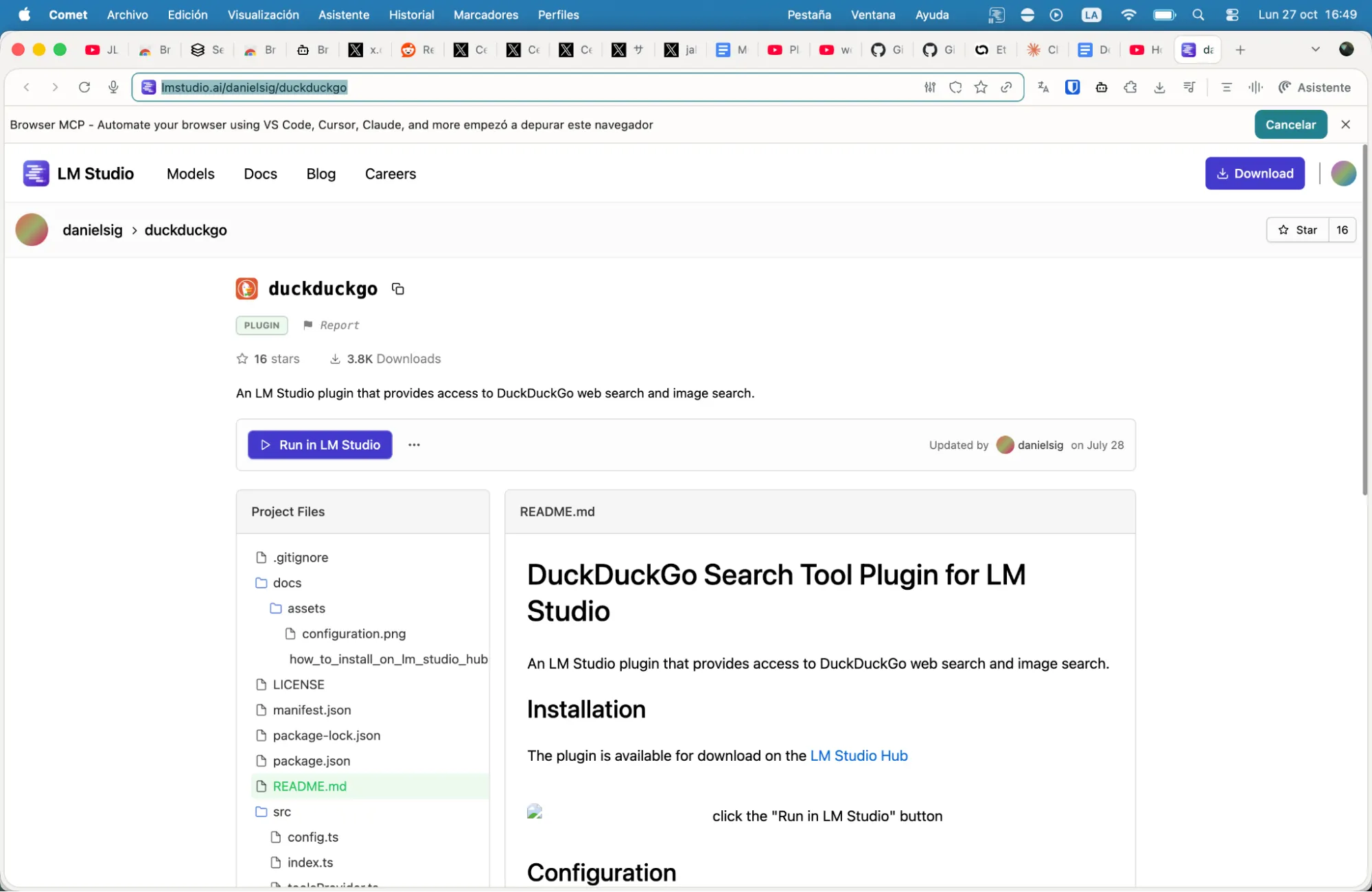

Para agregar DuckDuckGo, simplemente ve a lmstudio.ai/danielsig/duckduckgo y haz clic en el botón que dice "Run in LM Studio".

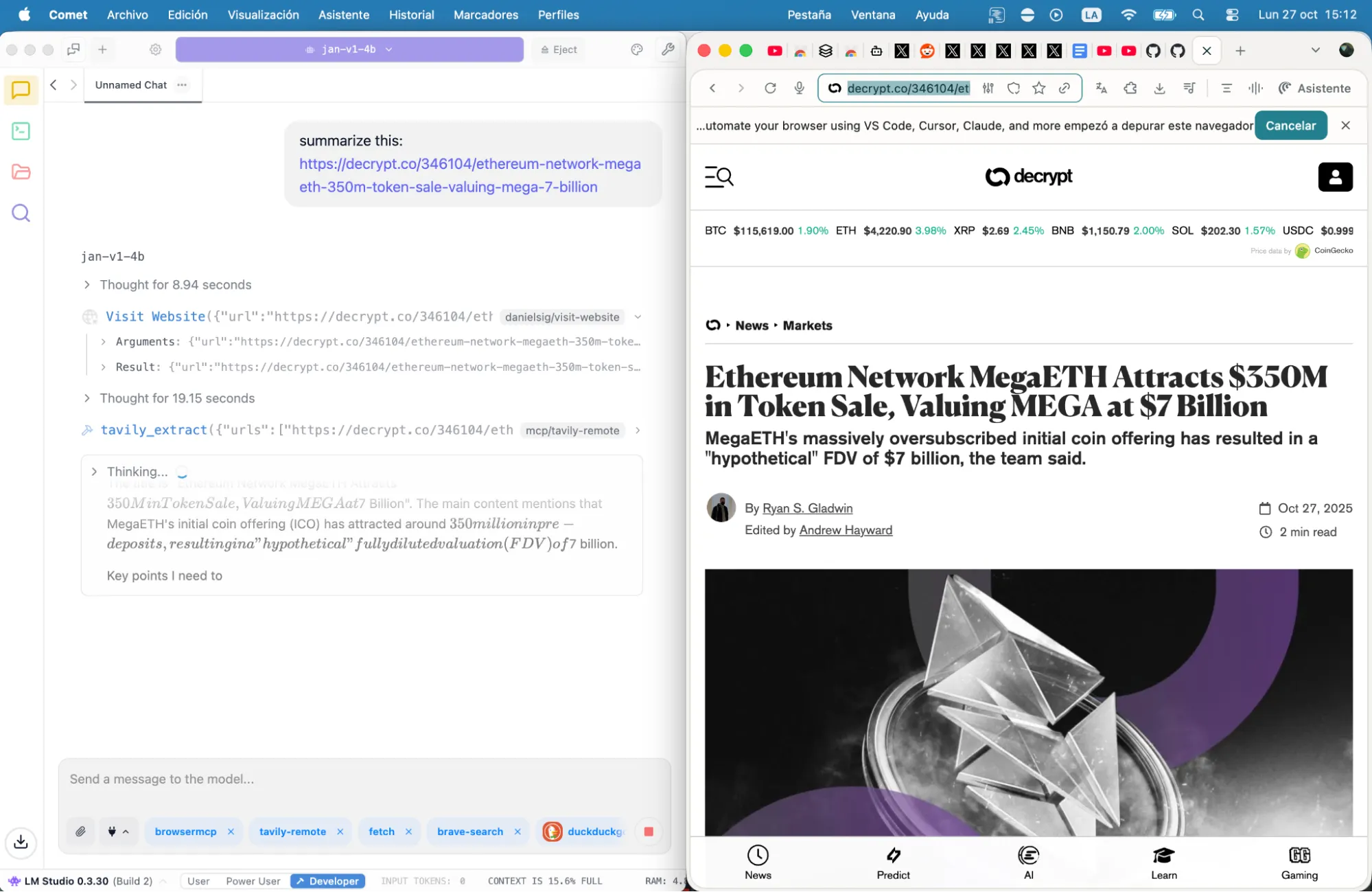

Luego ve a lmstudio.ai/danielsig/visit-website y haz lo mismo, haz clic en "Run in LM Studio".

Y eso es todo. Acabas de darle a tu modelo su primer superpoder. Ahora tienes tu propio SearchGPT gratis: local, privado y potenciado por DuckDuckGo.

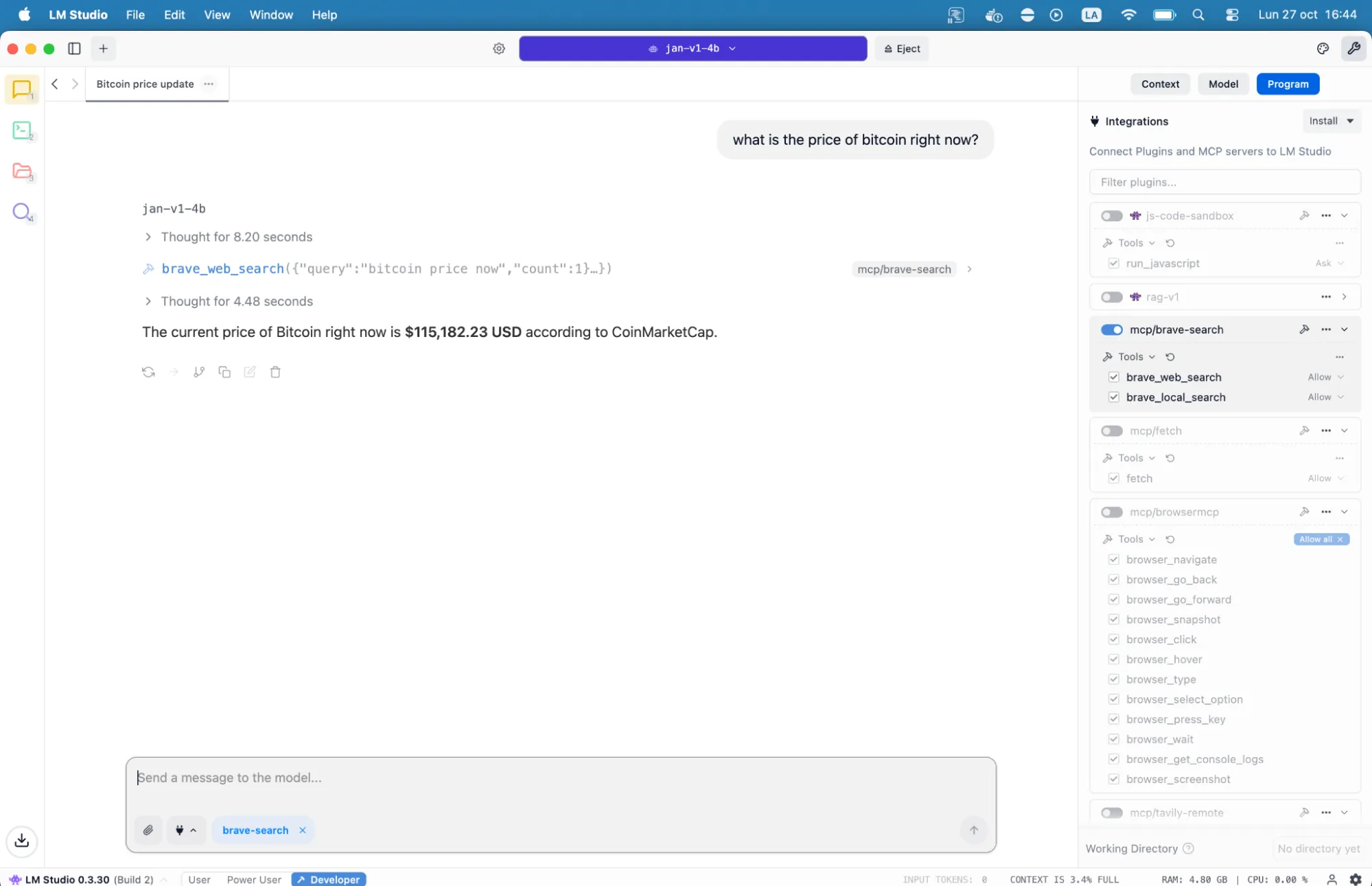

Pídele que encuentre las últimas noticias, el precio de Bitcoin, el clima, etc., y te dará información actualizada y relevante.

Brave Search es un poco más difícil de configurar que DuckDuckGo, pero ofrece un servicio más robusto, ejecutándose en un índice independiente de más de 30 mil millones de páginas y proporcionando 2.000 consultas gratuitas mensuales. Su enfoque en privacidad significa que no hay perfiles de usuario ni rastreo, lo que lo hace ideal para investigación sensible o consultas personales.

Para configurar Brave, regístrate en brave.com/search/api para obtener tu clave API. Requiere una verificación de pago, pero tiene un plan gratuito, así que no te preocupes.

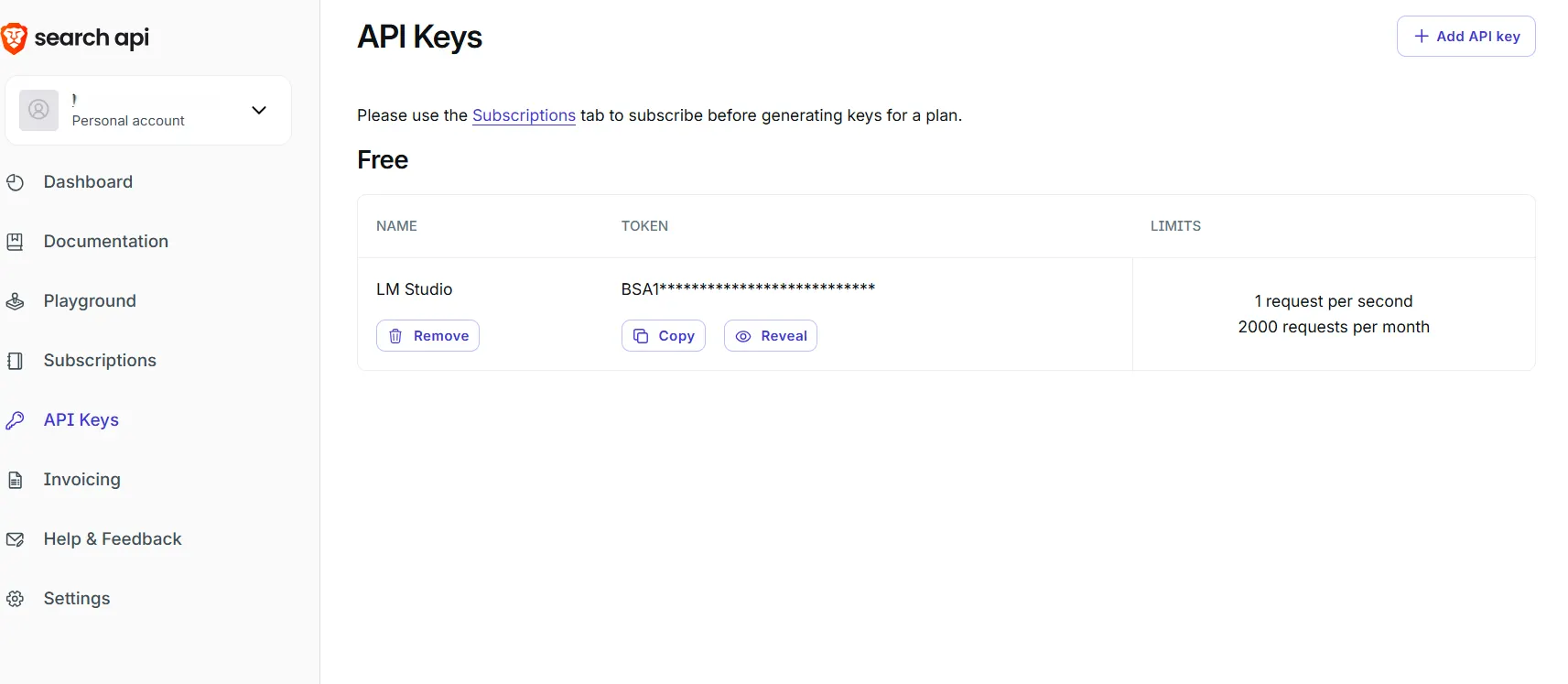

Una vez allí, ve a la sección "API Keys", haz clic en "Add API Key" y copia el nuevo código. No compartas ese código con nadie.

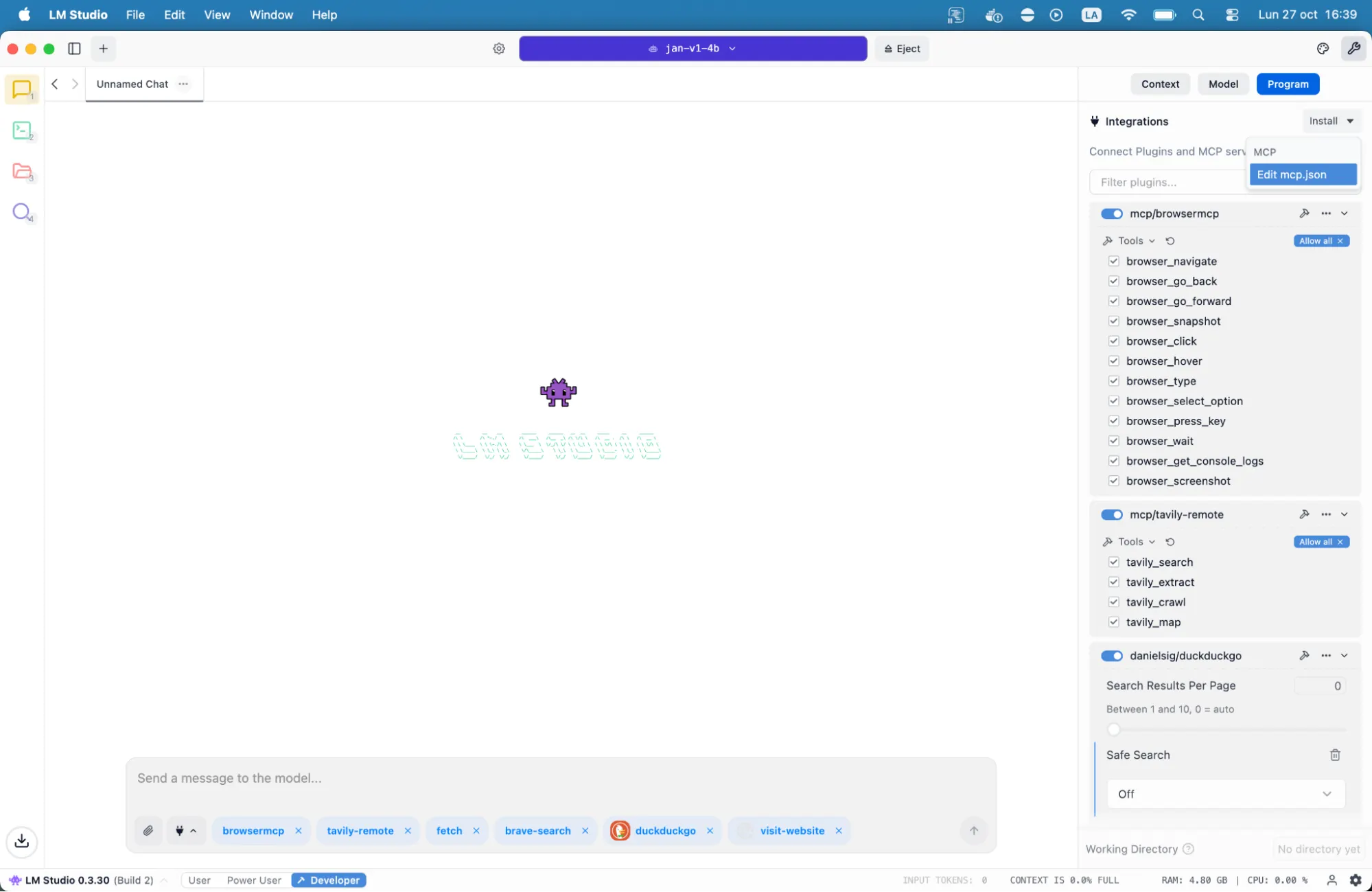

Luego ve a LM Studio, haz clic en el pequeño ícono de llave inglesa en la esquina superior derecha, luego haz clic en la pestaña "Program", después en el botón para Install and integration, haz clic en "Edit mcp.json".

Una vez allí, pega el siguiente texto en el campo que aparece. Recuerda poner la clave API secreta que acabas de crear dentro de las comillas donde dice "your brave api key here":

{

"mcpServers": {

"brave-search": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-brave-search"],

"env": {

"BRAVE_API_KEY": "your_brave_api_key_here"

}

}

}

}

Eso es todo. Ahora tu IA local puede navegar por la web usando Brave. Pregúntale cualquier cosa y te dará la información más actualizada que pueda encontrar.

Un periodista investigando noticias de última hora necesita información actual de múltiples fuentes. El índice independiente de Brave significa que los resultados no están filtrados a través de otros motores de búsqueda, proporcionando una perspectiva diferente sobre temas controversiales.

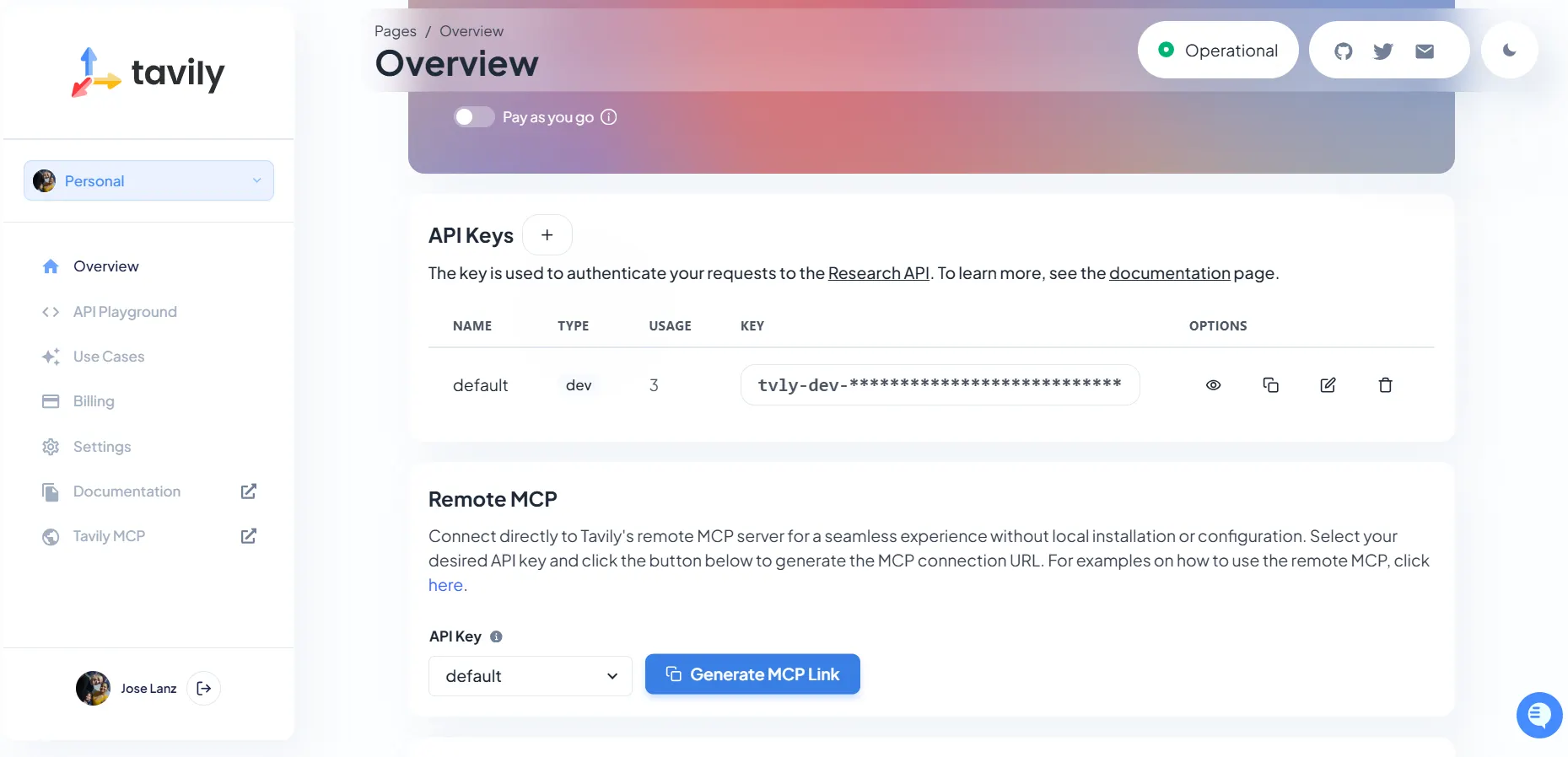

Tavily es otra gran herramienta para navegar por la web. Te da 1.000 créditos por mes y capacidades de búsqueda especializadas para noticias, código e imágenes. También es muy fácil de configurar: crea una cuenta en app.tavily.com, genera tu enlace MCP desde el panel de control y estás listo.

Luego, copia y pega la siguiente configuración en LM Studio, justo como lo hiciste con Brave. La configuración se ve así:

{

"mcpServers": {

"tavily-remote": {

"command": "npx",

"args": ["-y", "mcp-remote", "https://mcp.tavily.com/mcp/?tavilyApiKey=YOUR_API_KEY_HERE"]

}

}

}

Caso de uso: un desarrollador depurando un mensaje de error puede pedirle a su asistente de IA que busque soluciones, con la búsqueda enfocada en código de Tavily devolviendo discusiones de Stack Overflow y problemas de GitHub automáticamente formateados para análisis fácil.

Leyendo e interactuando con sitios web

Más allá de la búsqueda, MCP Fetch maneja un problema diferente: leer artículos completos. Los motores de búsqueda devuelven fragmentos, pero MCP Fetch recupera contenido completo de páginas web y lo convierte a formato markdown optimizado para procesamiento de IA. Esto significa que tu modelo puede analizar artículos completos, extraer puntos clave o responder preguntas detalladas sobre páginas específicas.

Simplemente copia y pega esta configuración. No necesitas crear claves API ni nada parecido:

{

"mcpServers": {

"fetch": {

"command": "uvx",

"args": [

"mcp-server-fetch"

]

}

Necesitas instalar un instalador de paquetes llamado uvx para ejecutar este. Solo sigue esta guía y estarás listo en un minuto o dos.

Esto es excelente para resumir, analizar, iterar o incluso mentoría. Un investigador podría darle una URL de un artículo técnico y preguntar: "Resume la sección de metodología e identifica posibles debilidades en su enfoque". El modelo obtiene el texto completo, lo procesa y proporciona análisis detallado que es imposible solo con fragmentos de búsqueda.

¿Quieres algo más simple? Este comando ahora es perfectamente comprensible incluso para tu IA local más tonta.

"Resume esto en tres párrafos y déjame saber por qué es tan importante: https://decrypt.co/es/346168/red-de-ethereum-megaeth-atrae-350-millones-en-venta-de-tokens-valuando-mega-en-7-000-millones/"

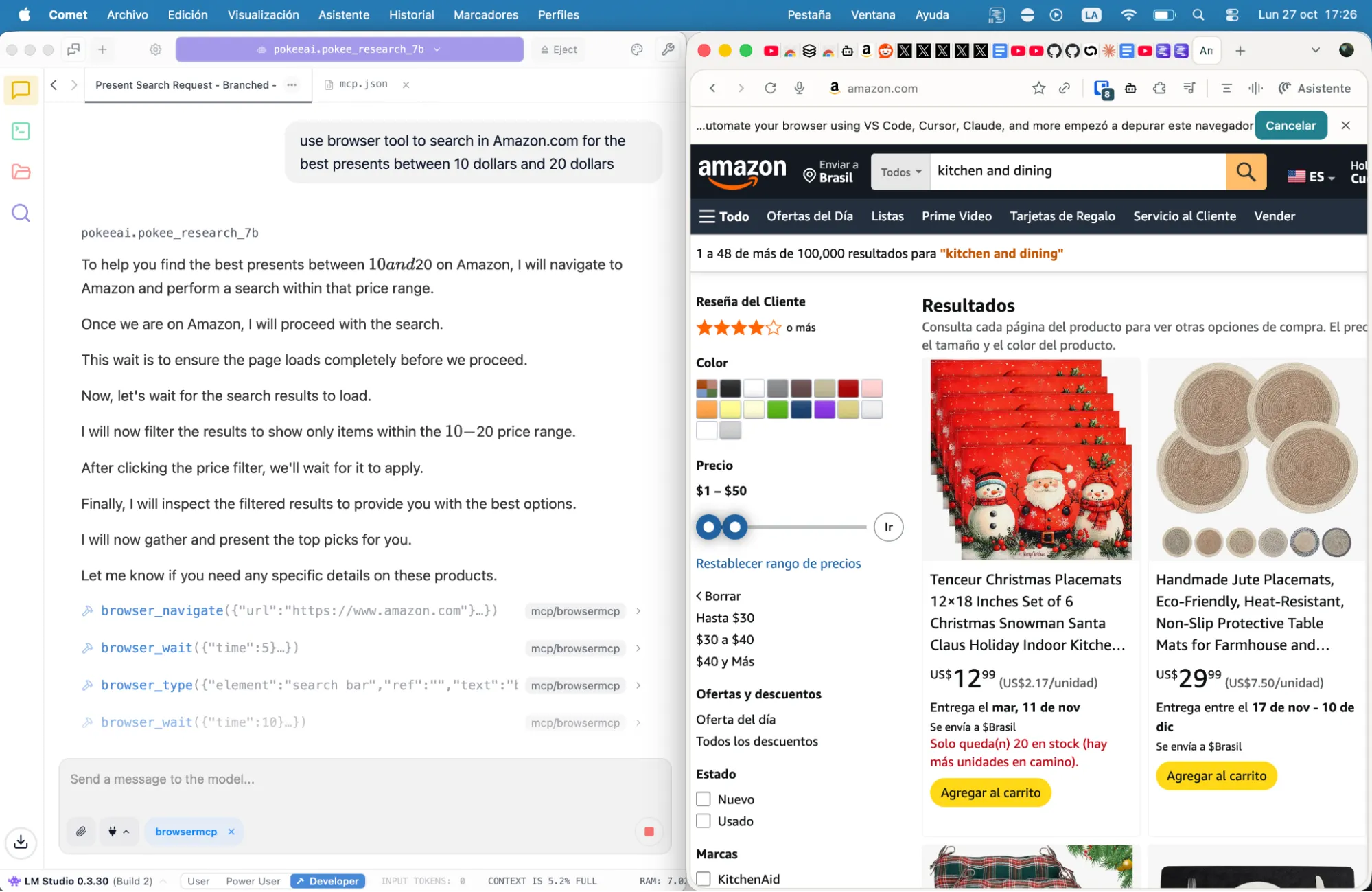

Hay muchas otras herramientas MCP para explorar, dándole a tus modelos diferentes capacidades. Por ejemplo, MCP Browser o Playwright permiten interacción con cualquier sitio web: llenado de formularios, navegación, incluso aplicaciones pesadas en JavaScript que los scrapers estáticos no pueden manejar. También hay servidores para auditorías SEO, ayudándote a aprender cosas con tarjetas Anki y mejorando tus capacidades de codificación.

La configuración completa

Si no quieres configurar manualmente tu LM Studio MCP.json, aquí hay un archivo completo que integra todos estos servicios.

Cópialo, añade tus claves API donde se indica, colócalo en tu directorio de configuración y reinicia tu aplicación de IA. Solo recuerda instalar las dependencias apropiadas:

{

"mcpServers": {

"fetch": {

"command": "uvx",

"args": [

"mcp-server-fetch"

]

},

"brave-search": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-brave-search"

],

"env": {

"BRAVE_API_KEY": "YOUR API KEY HERE"

}

},

"browsermcp": {

"command": "npx",

"args": [

"@browsermcp/mcp@latest"

]

},

"tavily-remote": {

"command": "npx",

"args": [

"-y",

"mcp-remote",

"https://mcp.tavily.com/mcp/?tavilyApiKey=YOUR API KEY HERE"

]

}

}

}

Esta configuración te dará acceso a Fetch, Brave, Tavily y MCP Browser, sin codificación requerida, sin procedimientos de configuración complejos, sin tarifas de suscripción y sin datos para grandes corporaciones, solo acceso web funcional para tus modelos locales.

De nada.