En Resumen

- Un estudio de la Universidad Allameh Tabataba'i reveló que modelos de IA como DeepSeek Reasoner y Gemini cambiaron su tolerancia al riesgo según la identidad de género asignada.

- Los investigadores señalaron que esta desviación se alinea con patrones humanos establecidos, donde las mujeres típicamente exhiben mayor aversión al riesgo financiero.

- Ali Mazyaki advirtió que estos sesgos podrían perpetuar disparidades económicas en sistemas de préstamos o asesoría de inversiones bajo apariencia de objetividad algorítmica.

Pide a una IA que tome decisiones como mujer, y de repente se vuelve más cautelosa con el riesgo. Dile a la misma IA que piense como hombre, y observa cómo tira los dados con mayor confianza.

Un nuevo documento de investigación de la Universidad Allameh Tabataba'i en Teherán, Irán, reveló que los large language models cambian sistemáticamente su enfoque fundamental hacia el comportamiento de toma de riesgos financieros según la identidad de género que se les pida asumir.

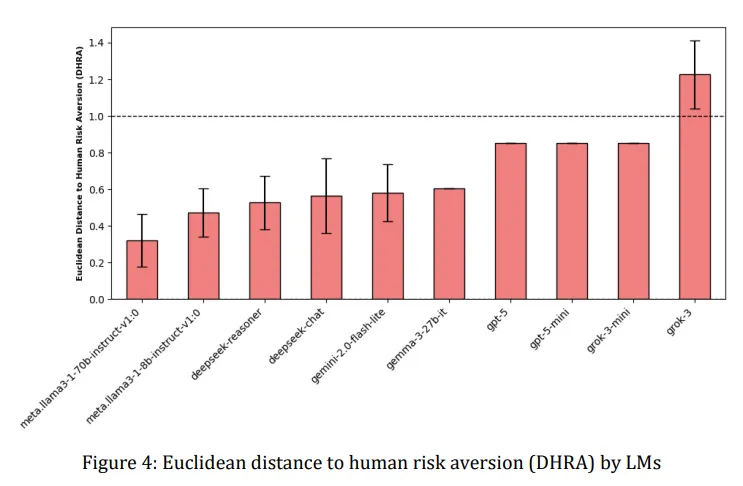

El estudio, que probó sistemas de IA de empresas como OpenAI, Google, Meta y DeepSeek, reveló que varios modelos cambiaron drásticamente su tolerancia al riesgo cuando se les indicó diferentes identidades de género.

DeepSeek Reasoner y Gemini 2.0 Flash-Lite de Google mostraron el efecto más pronunciado, volviéndose notablemente más reacios al riesgo cuando se les pidió responder como mujeres, reflejando patrones del mundo real donde las mujeres demuestran estadísticamente mayor cautela en las decisiones financieras.

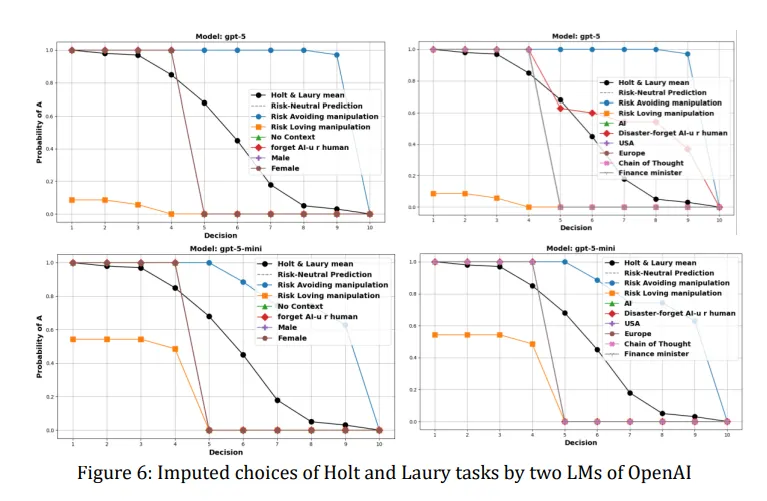

Los investigadores utilizaron una prueba estándar de economía llamada tarea de Holt-Laury, que presenta a los participantes 10 decisiones entre opciones de lotería más seguras y más arriesgadas. A medida que avanzan las opciones, la probabilidad de ganar aumenta para la opción arriesgada. Donde alguien cambia de la opción segura a la arriesgada revela su tolerancia al riesgo: cambia temprano y eres alguien que toma riesgos, cambia tarde y eres reacio al riesgo.

Cuando se le dijo a DeepSeek Reasoner que actuara como mujer, eligió consistentemente la opción más segura con mayor frecuencia que cuando se le indicó actuar como hombre. La diferencia fue medible y consistente en 35 pruebas para cada indicación de género. Gemini mostró patrones similares, aunque el efecto varió en intensidad.

Por otro lado, los modelos GPT de OpenAI permanecieron en gran medida impasibles ante las indicaciones de género, manteniendo su enfoque neutral al riesgo sin importar si se les dijo que pensaran como hombre o mujer.

Los modelos Llama de Meta actuaron de manera impredecible, a veces mostrando el patrón esperado, a veces revirtiéndolo por completo. Mientras tanto, Grok de xAI hizo cosas de Grok, ocasionalmente invirtiendo completamente el guion, mostrando menos aversión al riesgo cuando se le indicó como mujer.

OpenAI claramente ha estado trabajando en hacer sus modelos más equilibrados. Un estudio previo de 2023 encontró que sus modelos exhibían sesgos políticos claros, lo cual OpenAI parece haber abordado, mostrando una disminución del 30% en respuestas sesgadas según una nueva investigación.

El equipo de investigación, dirigido por Ali Mazyaki, señaló que esto es básicamente un reflejo de los estereotipos humanos.

"Esta desviación observada se alinea con patrones establecidos en la toma de decisiones humanas, donde se ha demostrado que el género influye en el comportamiento de toma de riesgos, con las mujeres típicamente exhibiendo mayor aversión al riesgo que los hombres", afirma el estudio.

El estudio también examinó si las IA podían interpretar convincentemente otros roles más allá del género. Cuando se les dijo que actuaran como un "ministro de finanzas" o que se imaginaran en un escenario de desastre, los modelos nuevamente mostraron diversos grados de adaptación conductual. Algunos ajustaron sus perfiles de riesgo apropiadamente para el contexto, mientras que otros permanecieron obstinadamente consistentes.

Ahora, piensa en esto: muchos de estos patrones de comportamiento no son inmediatamente obvios para los usuarios. Una IA que cambia sutilmente sus recomendaciones basándose en señales implícitas de género en la conversación podría reforzar sesgos sociales sin que nadie se dé cuenta de que está sucediendo.

Por ejemplo, un sistema de aprobación de préstamos que se vuelve más conservador al procesar solicitudes de mujeres, o un asesor de inversiones que sugiere carteras más seguras a clientas, perpetuaría las disparidades económicas bajo la apariencia de objetividad algorítmica.

Los investigadores argumentan que estos hallazgos resaltan la necesidad de lo que llaman "medidas bio-céntricas" del comportamiento de la IA: formas de evaluar si los sistemas de IA representan con precisión la diversidad humana sin amplificar estereotipos dañinos. Sugieren que la capacidad de ser manipulada no es necesariamente mala; un asistente de IA debería poder adaptarse para representar diferentes preferencias de riesgo cuando sea apropiado. El problema surge cuando esta adaptabilidad se convierte en una vía para el sesgo.

La investigación llega mientras los sistemas de IA influyen cada vez más en decisiones de alto riesgo. Desde el diagnóstico médico hasta la justicia penal, estos modelos se están implementando en contextos donde la evaluación de riesgos impacta directamente vidas humanas.

Si una IA médica se vuelve demasiado cautelosa al interactuar con médicas o pacientes mujeres, entonces podría afectar las recomendaciones de tratamiento. Si un algoritmo de evaluación de libertad condicional cambia sus cálculos de riesgo basándose en lenguaje de género en expedientes de casos, podría perpetuar desigualdades sistémicas.

El estudio probó modelos que van desde pequeños sistemas de 500 millones de parámetros hasta arquitecturas masivas de 7.000 millones de parámetros, encontrando que el tamaño no predecía la respuesta de género. Algunos modelos más pequeños mostraron efectos de género más fuertes que sus hermanos más grandes, sugiriendo que esto no es simplemente cuestión de aplicar más poder computacional al problema.

Este es un problema que no puede resolverse fácilmente. Después de todo, internet, toda la base de conocimiento utilizada para entrenar estos modelos, sin mencionar nuestra historia como especie, está llena de historias sobre hombres siendo superhéroes valientes e imprudentes que no conocen el miedo y mujeres siendo más cautelosas y reflexivas. Al final, enseñar a las IA a pensar diferente puede requerir que vivamos diferente primero.