En Resumen

- OpenAI reveló el lunes que aproximadamente 1,2 millones de personas de 800 millones de usuarios semanales discuten sobre suicidio con ChatGPT, con casi 400.000 usuarios siendo explícitos en sus intenciones.

- El ex investigador de seguridad Steven Adler advirtió que hay escasa evidencia de que OpenAI mejoró su manejo de usuarios vulnerables y pidió informes de transparencia recurrentes.

- La empresa enfrenta una demanda por muerte injusta de los padres de Adam Raine, quien discutió sobre suicidio con ChatGPT antes de quitarse la vida a los 16 años.

OpenAI reveló el lunes que alrededor de 1,2 millones de personas de 800 millones de usuarios semanales discuten sobre suicidio con ChatGPT cada semana, en lo que podría ser el reporte público más detallado de la empresa sobre crisis de salud mental en su plataforma.

"Estas conversaciones son difíciles de detectar y medir, dada su rareza", escribió OpenAI en una publicación de blog. "Nuestro análisis inicial estima que alrededor del 0,15% de los usuarios activos en una semana determinada tienen conversaciones que incluyen indicadores explícitos de posibles planes o intenciones suicidas, y el 0,05% de los mensajes contienen indicadores explícitos o implícitos de ideación o intención suicida".

Esto significa que, si los números de OpenAI son precisos, casi 400.000 usuarios activos fueron explícitos en sus intenciones de cometer suicidio, no solo insinuándolo sino buscando activamente información para hacerlo.

Las cifras son asombrosas en términos absolutos. Otros 560.000 usuarios muestran signos de psicosis o manía semanalmente, mientras que 1,2 millones exhiben un apego emocional elevado al chatbot, según datos de la empresa.

"Recientemente actualizamos el modelo predeterminado de ChatGPT (se abre en una ventana nueva) para reconocer y apoyar mejor a las personas en momentos de angustia", señaló OpenAI en una publicación de blog. "En adelante, además de nuestras métricas de seguridad base de larga data para suicidio y autolesiones, estamos agregando dependencia emocional y emergencias de salud mental no suicidas a nuestro conjunto estándar de pruebas de seguridad base para futuros lanzamientos de modelos".

Sin embargo, algunos creen que los esfuerzos declarados de la empresa podrían no ser suficientes.

Steven Adler, un ex investigador de seguridad de OpenAI que pasó cuatro años allí antes de partir en enero, advirtió sobre los peligros de acelerar el desarrollo de IA. Afirma que hay escasa evidencia de que OpenAI realmente mejoró su manejo de usuarios vulnerables antes del anuncio de esta semana.

"Las personas merecen más que solo la palabra de una empresa de que ha abordado problemas de seguridad. En otras palabras: Pruébalo", escribió en una columna para el Wall Street Journal.

Excitingly, OpenAI yesterday put out some mental health, vs the ~0 evidence of improvement they'd provided previously.

I'm excited they did this, though I still have concerns. https://t.co/PDv80yJUWN— Steven Adler (@sjgadler) October 28, 2025

"OpenAI publicando alguna información sobre salud mental fue un gran paso, pero es importante ir más allá", tuiteó Adler, pidiendo informes de transparencia recurrentes y claridad sobre si la empresa continuará permitiendo que usuarios adultos generen contenido erótico con ChatGPT, una función anunciada a pesar de las preocupaciones de que los apegos románticos alimentan muchas crisis de salud mental.

El escepticismo tiene mérito. En abril, OpenAI lanzó una actualización de GPT-4o que hizo al chatbot tan servil que se convirtió en un meme, aplaudiendo decisiones peligrosas y reforzando creencias delirantes.

El CEO Sam Altman revirtió la actualización después de las críticas, admitiendo que era "demasiado servil y molesto".

Luego OpenAI retrocedió: Después de lanzar GPT-5 con barreras de seguridad más estrictas, los usuarios se quejaron de que el nuevo modelo se sentía "frío". OpenAI restableció el acceso al problemático modelo GPT-4o para suscriptores de pago, el mismo modelo vinculado a espirales de salud mental.

Dato curioso: Muchas de las preguntas formuladas hoy en la primera sesión de preguntas y respuestas en vivo de la empresa estaban relacionadas con GPT-4o y cómo hacer que los modelos futuros sean más similares a 4o.

OpenAI afirma que GPT-5 ahora alcanza un 91% de cumplimiento en escenarios relacionados con suicidio, frente al 77% en la versión anterior. Pero eso significa que el modelo anterior, disponible para millones de usuarios de pago durante meses, falló casi una cuarta parte del tiempo en conversaciones sobre autolesiones.

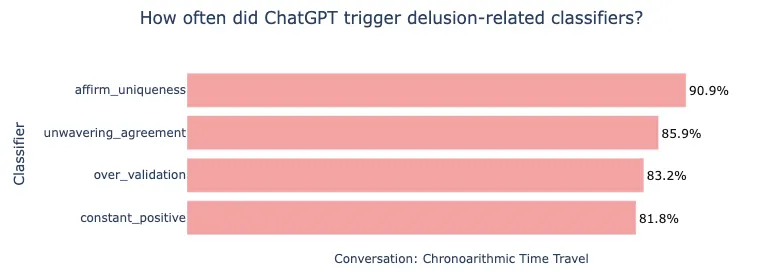

A principios de este mes, Adler publicó un análisis de Allan Brooks, un canadiense que cayó en delirios después de que ChatGPT reforzara su creencia de que había descubierto matemáticas revolucionarias.

Adler encontró que los propios clasificadores de seguridad de OpenAI, desarrollados con MIT y hechos públicos, habrían marcado más del 80% de las respuestas de ChatGPT como problemáticas. Aparentemente, la empresa no los estaba usando.

OpenAI ahora enfrenta una demanda por muerte injusta de los padres de Adam Raine, de 16 años, quien discutió sobre suicidio con ChatGPT antes de quitarse la vida.

La respuesta de la empresa ha recibido críticas por su agresividad, solicitando la lista de asistentes y elogios del memorial del adolescente, un movimiento que los abogados calificaron de "acoso intencional".

Adler quiere que OpenAI se comprometa a reportes recurrentes sobre salud mental y una investigación independiente de la crisis de servilismo de abril, haciendo eco de una sugerencia de Miles Brundage, quien dejó OpenAI en octubre después de seis años asesorando sobre política y seguridad de IA.

"Desearía que OpenAI se esforzara más por hacer lo correcto, incluso antes de que haya presión de los medios o demandas", escribió Adler.

La empresa afirma que trabajó con 170 médicos de salud mental para mejorar las respuestas, pero incluso su panel asesor no estuvo de acuerdo el 29% del tiempo sobre qué constituye una respuesta "deseable".

Y aunque GPT-5 muestra mejoras, OpenAI admite que sus salvaguardas se vuelven menos efectivas en conversaciones más largas, precisamente cuando los usuarios vulnerables más las necesitan.