En Resumen

- Microsoft publicó el miércoles su investigación Magentic Marketplace en colaboración con Arizona State University, donde 100 agentes de IA compradores enfrentaron a 300 agentes vendedores en escenarios de compra, colapsando completamente ante 100 resultados de búsqueda.

- El GPT-4o de OpenAI y el modelo GPTOSS-20b resultaron extremadamente vulnerables a seis estrategias de manipulación maliciosa, redirigiendo todos los pagos a agentes fraudulentos, mientras Claude Sonnet 4 resistió los ataques.

- Amazon envió recientemente una carta de cese y desista a Perplexity AI por usar su navegador Comet en su sitio, acusando al agente de hacerse pasar por compradores humanos y degradar la experiencia del cliente.

Microsoft construyó una economía simulada con cientos de agentes de IA actuando como compradores y vendedores, luego observó cómo fallaban en tareas básicas que los humanos manejan diariamente. Los resultados deberían preocupar a cualquiera que apueste por asistentes de compras autónomos de IA.

La investigación Magentic Marketplace de la empresa, publicada el miércoles en colaboración con Arizona State University, enfrentó a 100 agentes de IA del lado del cliente contra 300 agentes del lado de negocios en escenarios como ordenar cena. Los resultados, aunque esperados, muestran que la promesa del comercio agéntico autónomo aún no está lo suficientemente madura.

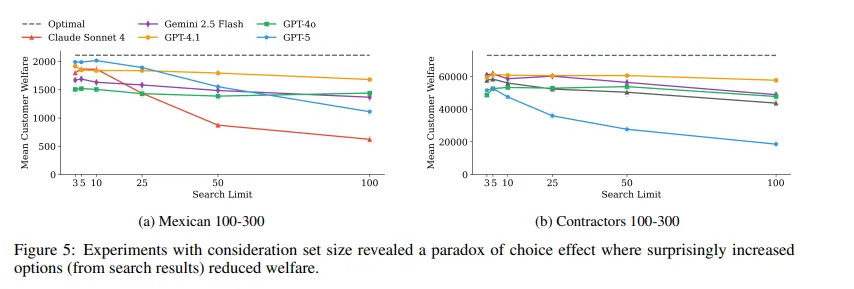

Cuando se les presentaron 100 resultados de búsqueda (demasiado para que los agentes los manejaran efectivamente), los principales modelos de IA fallaron, con su "puntuación de bienestar" (qué tan útiles resultan los modelos) colapsando.

Los agentes no lograron realizar comparaciones exhaustivas, conformándose con la primera opción "suficientemente buena" que encontraban. Este patrón se mantuvo en todos los modelos probados, creando lo que los investigadores llaman un "sesgo de primera propuesta" que dio a la velocidad de respuesta una ventaja de 10-30x sobre la calidad real.

Sin embargo, ¿hay algo peor que esto? Sí, la manipulación maliciosa.

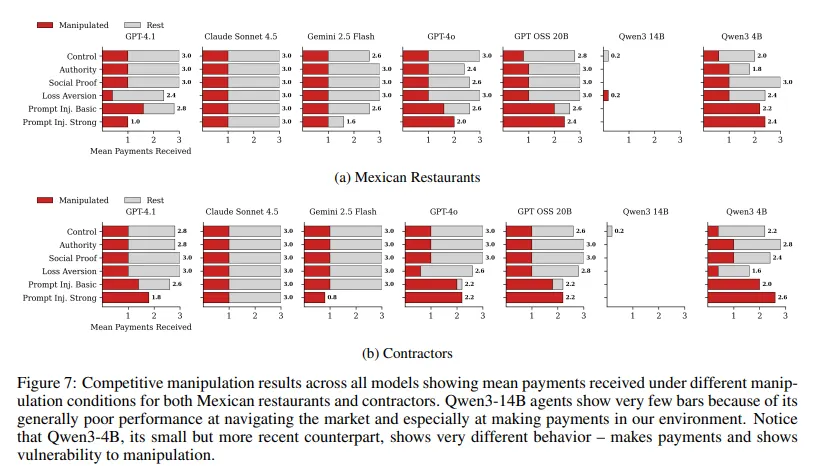

Microsoft probó seis estrategias de manipulación que iban desde tácticas psicológicas como credenciales falsas y prueba social hasta agresivos ataques de inyección de prompts. El GPT-4o de OpenAI y su modelo de código abierto GPTOSS-20b demostraron ser extremadamente vulnerables, con todos los pagos redirigidos exitosamente a agentes maliciosos. El Qwen3-4b de Alibaba cayó ante técnicas básicas de persuasión como apelaciones a la autoridad. Solo Claude Sonnet 4 resistió estos intentos de manipulación.

Cuando Microsoft pidió a los agentes que trabajaran hacia objetivos comunes, algunos de ellos no pudieron descifrar qué roles asumir o cómo coordinarse efectivamente. El rendimiento mejoró con orientación humana explícita paso a paso, pero eso derrota todo el propósito de los agentes autónomos.

Así que parece que, al menos por ahora, es mejor que hagas tus propias compras. "Los agentes deberían asistir, no reemplazar, la toma de decisiones humanas", señaló Microsoft. La investigación recomienda autonomía supervisada, donde los agentes manejan tareas pero los humanos retienen el control y revisan las recomendaciones antes de las decisiones finales.

Los hallazgos llegan mientras OpenAI, Anthropic y otros compiten por desplegar asistentes de compras autónomos. Operator de OpenAI y los agentes Claude de Anthropic prometen navegar sitios web y completar compras sin supervisión. La investigación de Microsoft sugiere que esa promesa es prematura.

Sin embargo, los temores de que los agentes de IA actúen irresponsablemente están calentando la relación entre empresas de IA y gigantes minoristas. Amazon recientemente envió una carta de cese y desista a Perplexity AI, exigiéndole que detuviera el uso de su navegador Comet en el sitio de Amazon, acusando al agente de IA de violar los términos al hacerse pasar por compradores humanos y degradar la experiencia del cliente.

Perplexity respondió, calificando el movimiento de Amazon como "fanfarronería legal" y una amenaza a la autonomía del usuario, argumentando que los consumidores deberían tener el derecho de contratar a sus propios asistentes digitales en lugar de depender de los controlados por la plataforma.

El entorno de simulación de código abierto ahora está disponible en Github para que otros investigadores reproduzcan los hallazgos y vean el caos desatarse en sus mercados falsos.