En Resumen

- Nikon, Sony y Canon proponen incrustar firmas digitales en fotos reales para certificar su origen digital, luchando contra la desinformación.

- Las firmas incluirán metadatos clave y se aplicarán directamente desde las cámaras sin espejo, ofreciendo pruebas irrefutables de la credibilidad de las imágenes.

- La iniciativa, respaldada por un estándar abierto llamado "Verify", busca combatir el contenido falso en línea y proporcionar verificación gratuita en línea de la autenticidad de las fotos.

A medida que las fotos y videos generados por IA realistas proliferan en línea, las empresas de tecnología y los grupos de vigilancia están compitiendo para desarrollar herramientas que identifiquen el contenido falso.

Agregar marcas de agua a las imágenes generadas por computadora es una solución comúnmente propuesta, agregando una bandera invisible en forma de metadatos ocultos que ayudan a revelar que una imagen fue creada utilizando una herramienta de IA generativa. Pero los investigadores han encontrado que dicha marca de agua tiene una gran falla: las técnicas adversarias pueden eliminarla fácilmente.

Ahora, los principales fabricantes de cámaras están proponiendo un enfoque diferente, lo opuesto en cierto sentido: incrustar marcas de agua en fotografías "reales".

Nikon, Sony y Canon anunciaron recientemente una iniciativa conjunta para incluir firmas digitales en imágenes tomadas directamente desde sus cámaras sin espejo de alta gama. Según Nikkei Asia, las firmas integrarán metadatos clave como la fecha, hora, ubicación GPS y detalles del fotógrafo, certificando criptográficamente el origen digital de cada foto.

Nikon dijo que lanzará esta función en su próxima línea de cámaras sin espejo profesionales; Sony emitirá actualizaciones de firmware para insertar firmas digitales en sus cámaras sin espejo actuales; y Canon tiene la intención de lanzar cámaras con autenticación incorporada en 2024, junto con marcas de agua en video más adelante ese año.

El objetivo, según informa Nikkei, es proporcionar a los fotoperiodistas, profesionales de los medios y artistas pruebas irrefutables de la credibilidad de sus imágenes. Las firmas a prueba de manipulaciones no desaparecerán con las ediciones y deberían ayudar en los esfuerzos para combatir la desinformación y el uso fraudulento de fotos en línea.

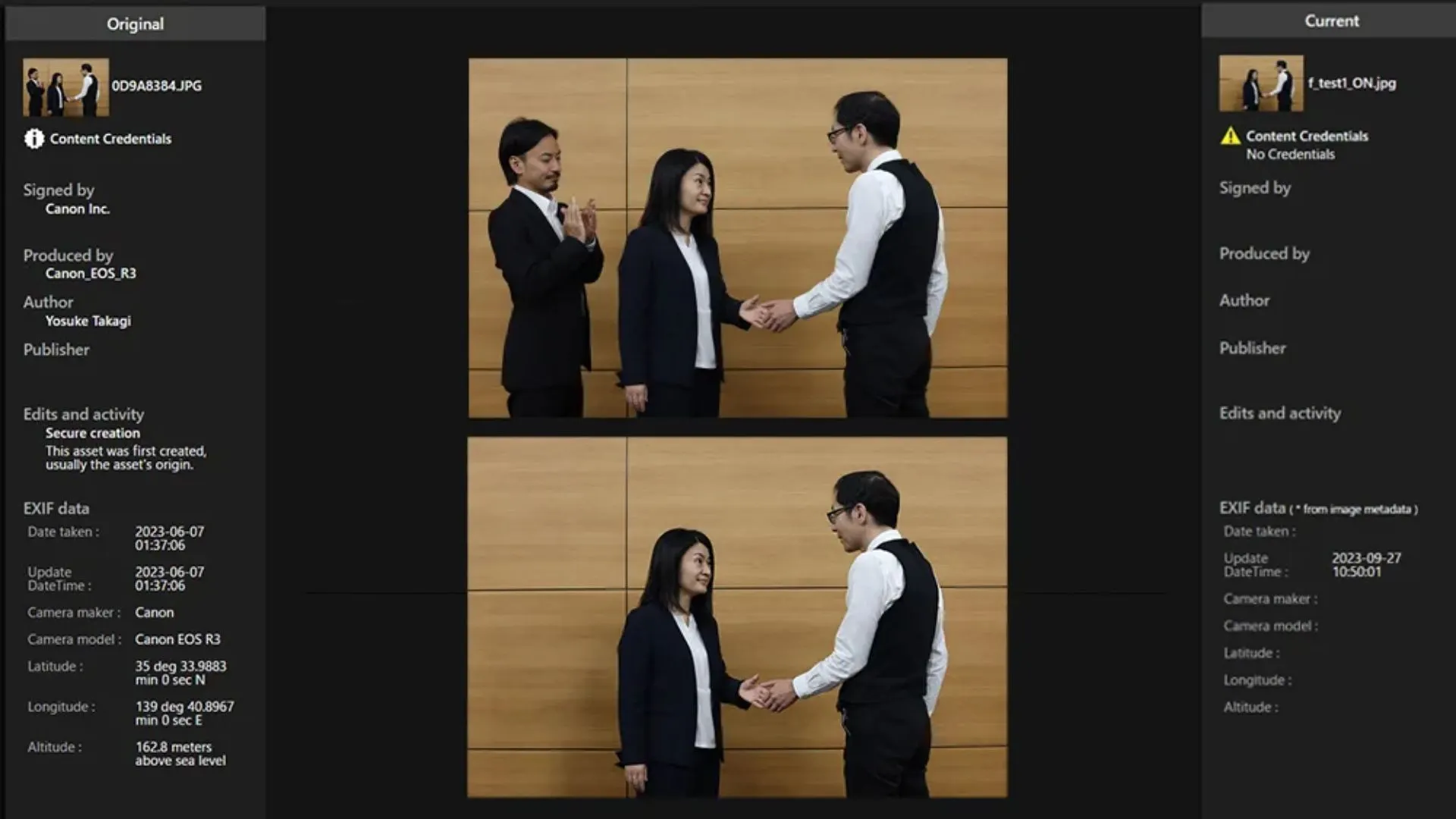

Para respaldar esto, las empresas colaboraron en un estándar abierto para firmas digitales interoperables llamado "Verify". Una vez implementado, las fotos tomadas con hardware adecuado podrán ser verificadas en línea de forma gratuita para que las personas puedan determinar si una foto es auténtica o no.

Si una foto generada por IA intenta pasar el sistema Verify sin una firma auténtica, se etiqueta como "Sin Credenciales de Contenido".

En lugar de marcar retroactivamente el contenido de IA, el plan autentica directamente las fotos reales en su origen. Pero al igual que cualquier otro sistema de marca de agua, su éxito dependerá de una adopción generalizada (si más fabricantes de hardware incorporan el estándar) y una implementación a prueba de tiempo (el código evoluciona para permanecer invulnerable).

Según Decrypt informó, investigaciones recientes indican que las técnicas contra marcas de agua también podrían comprometer las firmas incrustadas, volviendo inútiles los métodos actuales de marca de agua. Sin embargo, esto solo convierte las imágenes con marca de agua en imágenes sin marca de agua, por lo que las personas tienen menos herramientas para detectar su artificialidad.

Si bien las técnicas contra marcas de agua podrían eliminar las firmas de autenticidad de las fotos reales, esto es menos problemático que eliminar las marcas de agua de las imágenes falsas generadas por IA. ¿Por qué? Si se elimina una marca de agua de un deepfake de IA, permite que el contenido falsificado se presente como real con mayor facilidad. Sin embargo, si se eliminan las firmas de autenticación de las fotos reales, la imagen restante aún es capturada por una cámara, no se origina a partir de un modelo generativo. Aunque pierde su prueba criptográfica, el contenido subyacente sigue siendo genuino.

El riesgo principal en ese caso está relacionado con la atribución y la gestión de derechos, no con la veracidad del contenido. La imagen podría ser atribuida incorrectamente o utilizada sin la licencia adecuada, pero no engaña inherentemente a los espectadores sobre la realidad que representa.

OpenAI anunció recientemente un detector de deepfakes impulsado por IA que afirma tener una precisión del 99% en imágenes. Sin embargo, los detectores de IA siguen siendo imperfectos y requieren actualizaciones constantes para superar las evoluciones en la tecnología generativa.

El auge reciente en la sofisticación de los deepfakes ha puesto de manifiesto la necesidad de estrategias como esta. Como hemos visto en 2023, la necesidad de diferenciar entre contenido real y fabricado nunca ha sido tan acuciante. Tanto los políticos como los desarrolladores de tecnología están buscando soluciones viables, por lo que sin duda se agradece un poco de ayuda por parte de estas empresas.

Editado por Ryan Ozawa.